详细介绍

GROOVY 是一个面向 **AI Agent 开发者与团队** 的**智能体运行指挥中心(Command Center)**。它的核心使命是帮助用户高效地**部署、监控、调试和规模化运营 AI Agent**,解决在真实生产环境中常见的响应延迟、行为不可控、状态不透明、调试困难等关键挑战。

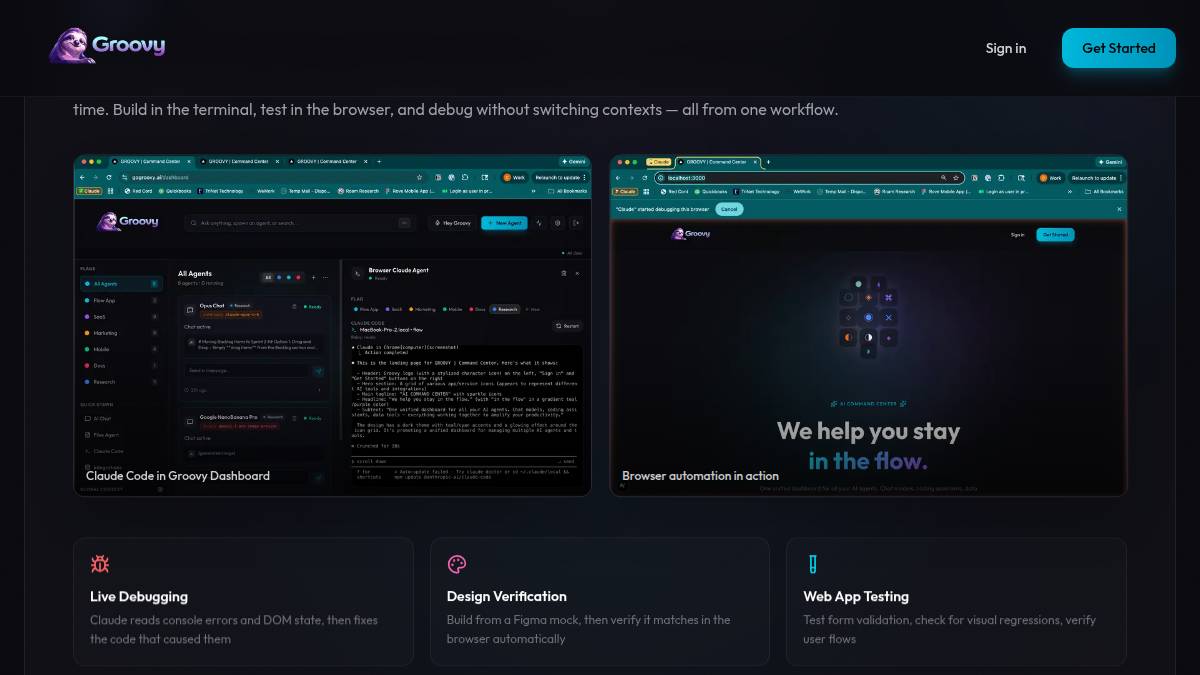

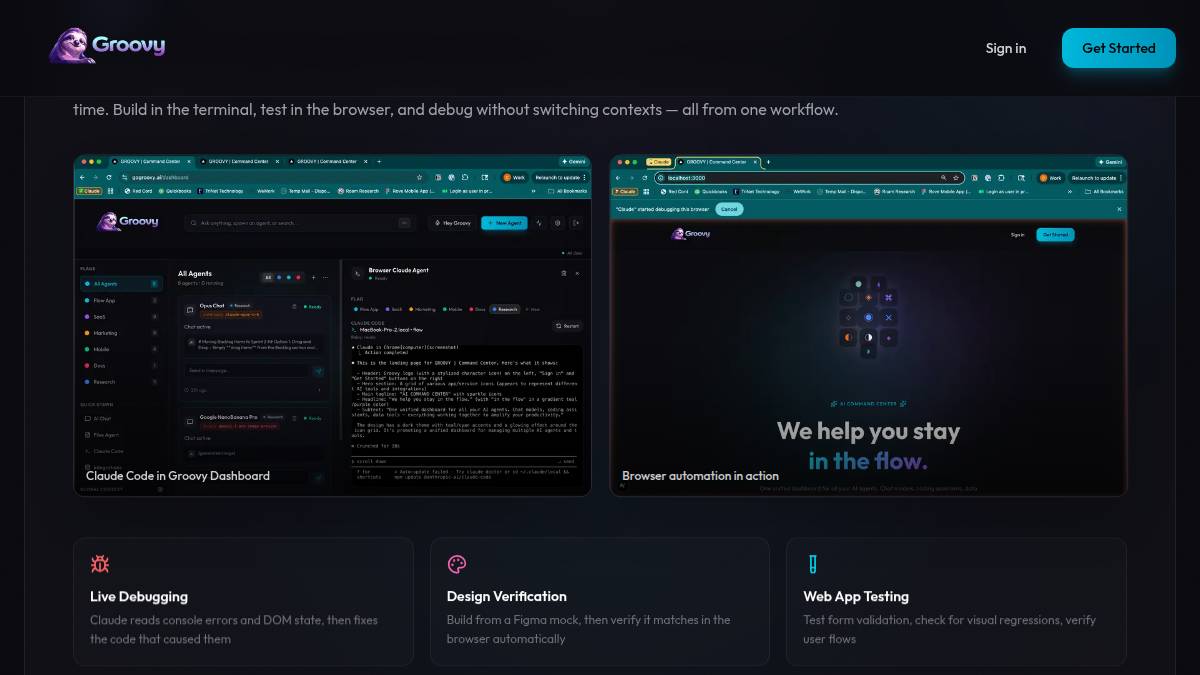

通过提供一体化的**实时会话追踪、多维度性能仪表盘、可视化工作流编排、上下文快照回溯、以及可扩展的集成能力**,GROOVY 让开发者从“黑盒式调用”走向“全链路可观测”,显著提升 Agent 的稳定性、可维护性与交付效率。

📊 核心价值与量化收益

70%

降低 Agent 调试时间

3x

提升问题定位速度

100%

全链路会话可追溯

即时

响应异常行为告警

🧱 核心技术模块

| 模块 | 功能描述 |

|---|---|

| 实时会话追踪(Live Session Trace) | 毫秒级捕获每次 Agent 调用的完整生命周期,包括输入、工具调用、LLM 请求/响应、中间状态与最终输出。 |

| 智能体性能仪表盘(Agent Performance Dashboard) | 可视化呈现延迟分布、成功率、Token 消耗、工具调用频次等核心指标,支持按 Agent、版本、用户分组分析。 |

| 上下文快照回溯(Context Snapshot) | 自动保存关键节点的完整上下文(含记忆、工具返回、历史对话),支持一键复现与本地调试,告别“无法复现”的困境。 |

| 可视化工作流编排(Visual Flow Editor) | 拖拽式构建与编辑 Agent 执行逻辑,直观查看决策路径、条件分支与工具依赖,大幅提升协作与迭代效率。 |

| 异常行为智能告警(Smart Anomaly Alert) | 基于时序模式识别潜在风险(如循环调用、超长响应、高频失败),实时推送至 Slack / Email / Webhook。 |

| 开放集成生态(Open Integrations) | 原生支持 LangChain、LlamaIndex、AutoGen、Ollama 及主流 LLM API;提供 SDK 与 Webhook,轻松嵌入现有工程栈。 |

💰 定价方案

GROOVY 采用简洁透明的月度订阅制,无隐藏费用,所有功能对开发者完全开放。

| 方案 | 定价 | 核心权益 | 适用阶段 |

|---|---|---|---|

| 免费版 | 免费 1,000 会话/月 |

实时追踪、基础仪表盘、上下文快照、Slack 告警 | 个人学习与原型验证 |

| 专业版 | $29/月 10,000 会话/月 |

增加:可视化工作流编排、自定义告警规则、Email/Webhook 集成、高级过滤与搜索 | 团队协作与早期产品上线 |

| 团队版 | $99/月 50,000 会话/月 |

增加:成员管理、角色权限控制、审计日志、专属技术支持、SSO(SAML) | 多项目协同与客户交付 |

| 企业版 | 定制 不限会话量 + 私有化部署选项 |

全面能力,含 VPC 部署、GDPR 合规支持、SLA 保障、专属客户成功经理 | 大规模生产环境与关键业务场景 |

🎯 解决的核心开发与运维问题

| 痛点场景 | 导致的后果 | GROOVY 的解决方案 |

|---|---|---|

| “调用即黑盒” | 无法看清 Agent 内部执行步骤、工具选择逻辑与上下文变化,问题排查靠猜。 | Live Session Trace 提供端到端执行链路图,每步均可展开查看原始数据与耗时。 |

| “线上问题难复现” | 用户反馈“Agent 回答错误”,但本地无法重现,缺乏现场上下文。 | 自动捕获并持久化异常会话的完整 Context Snapshot,支持一键下载至本地环境复现调试。 |

| “性能瓶颈不明确” | 整体响应慢,但无法判断是 LLM 延迟、工具超时,还是逻辑循环导致。 | 多维仪表盘按组件(LLM/Tool/Memory)拆解延迟与成功率,精准定位瓶颈环节。 |

| “团队协作低效” | Agent 逻辑散落在代码中,新人上手难;修改逻辑需反复改代码+部署,迭代慢。 | 可视化 Flow Editor 将逻辑外化为可读性强的图形化流程,支持版本对比与快速发布。 |