详细介绍

Ollama 是一个专为在**本地运行大型语言模型(LLM)**而设计的工具。它让用户能够轻松地在自己的设备上下载、运行和管理开源大模型,同时确保数据安全。

Ollama 提供了简洁的命令行接口和 API,支持与多种流行开发工具(如 LangChain、LlamaIndex 等)集成,帮助开发者快速构建基于本地 AI 模型的应用程序,无需依赖云端服务。

📊 核心价值与量化收益

本地运行

数据永不离开您的设备

一键部署

简化模型下载与启动流程

开源模型

支持 Llama、Mistral 等主流开源模型

开发者友好

提供 REST API 和 CLI 工具

🧱 核心技术模块

| 模块 | 功能描述 |

|---|---|

| 本地模型运行 | 在 macOS、Linux 和 Windows 上直接运行开源大语言模型,无需互联网连接。 |

| 模型库集成 | 通过 ollama.com 模型库一键发现和下载热门开源模型(如 Llama 3、Mistral、Gemma 等)。 |

| REST API | 提供标准 HTTP API,便于与现有应用集成,支持流式响应和自定义提示模板。 |

| 开发者工具链 | 与 LangChain、LlamaIndex、AnythingLLM 等主流 RAG 和 AI 开发框架无缝集成。 |

| 命令行界面 (CLI) | 通过简单命令(如 ollama run llama3)快速启动和交互模型。 |

| 数据隐私保障 | 所有推理过程在本地完成,敏感数据不会上传至任何第三方服务器。 |

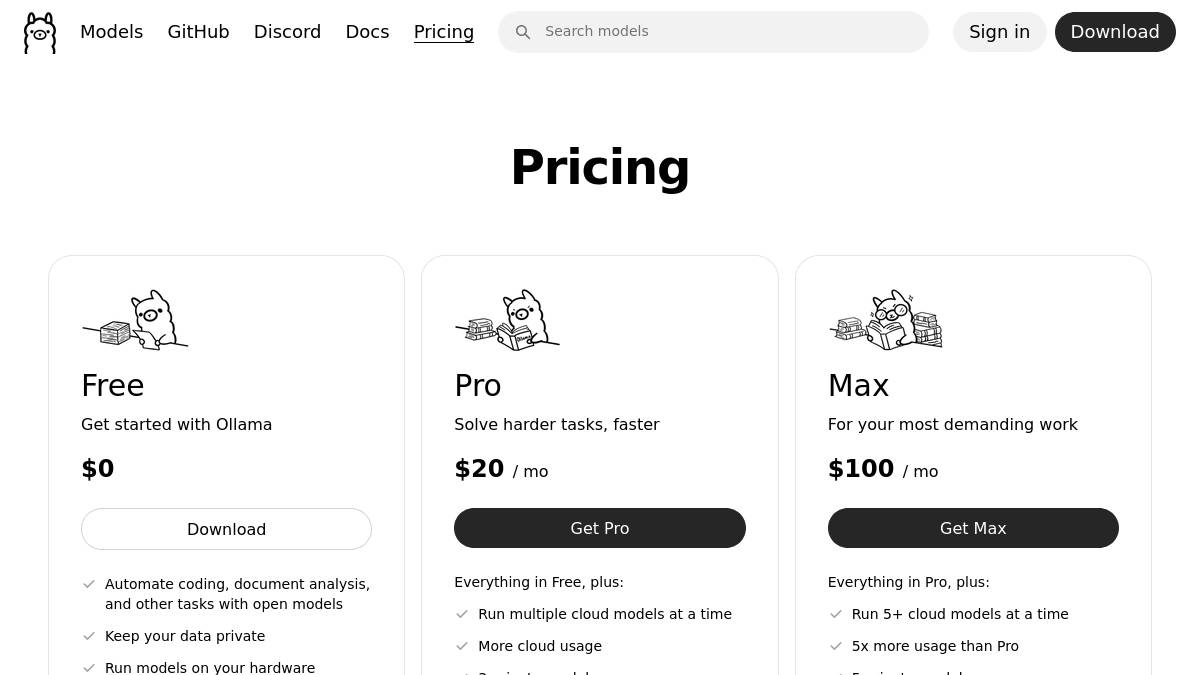

💰 定价方案

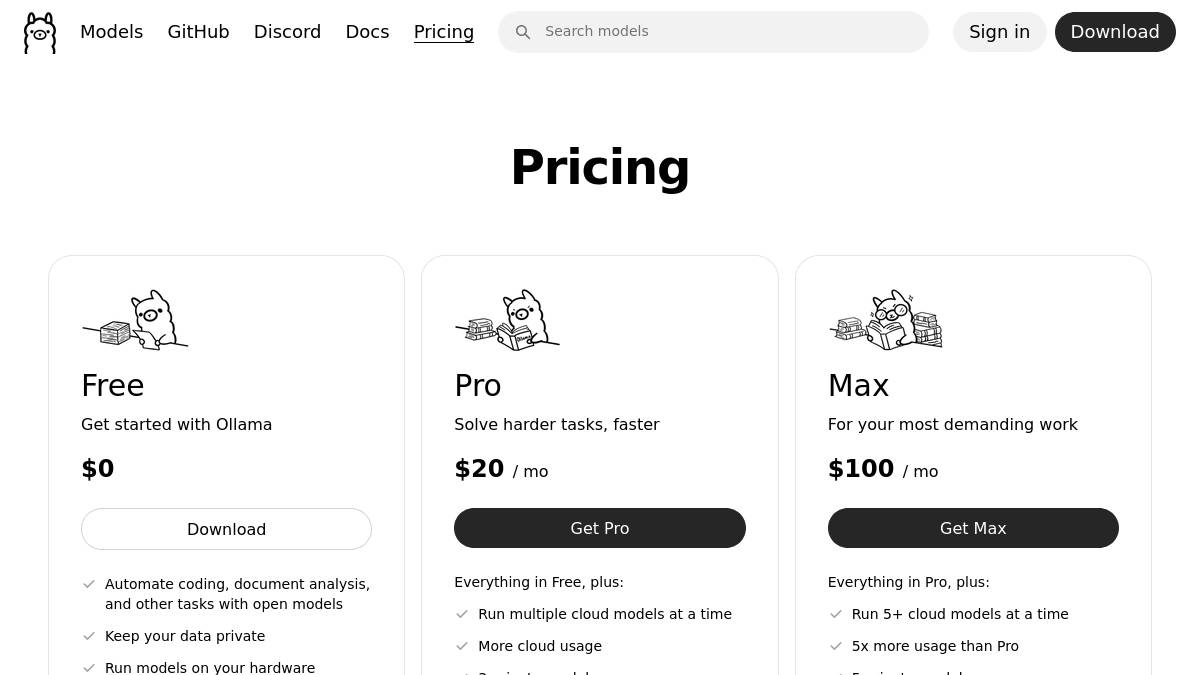

Ollama 是一个开源项目,核心功能完全免费。其云服务(Ollama Cloud)提供托管选项,但官网未公开具体价格。

| 方案 | 定价 | 核心权益 | 适用阶段 |

|---|---|---|---|

| 桌面版(开源) | 免费 | 本地运行开源模型、CLI、REST API、全平台支持(macOS/Linux/Windows) | 个人开发者、研究、本地应用 |

| Ollama Cloud | 联系咨询 | 托管模型服务、团队协作、API 访问、企业级支持(根据官网 /pricing 页面) | 团队或企业需要云端托管 |

🎯 解决的核心问题

| 痛点 | 导致的后果 | Ollama 的解决方案 |

|---|---|---|

| 数据隐私风险 | 使用云端 API 可能导致敏感数据泄露或合规问题。 | 所有模型在本地运行,数据完全保留在用户设备上。 |

| 开源模型部署复杂 | 手动配置环境、依赖和权重文件门槛高,耗时长。 | 一键下载和运行模型,自动处理依赖和优化。 |

| 缺乏标准化接口 | 不同模型有不同调用方式,难以集成到统一应用中。 | 提供统一的 REST API 和 CLI,简化集成流程。 |

| 开发效率低下 | 反复调试环境和模型加载逻辑,拖慢原型开发速度。 | 开箱即用,几分钟内即可开始与模型交互。 |